Casos reais de IA explicável (XAI): Lições essenciais para quem lidera a inovação nas empresas

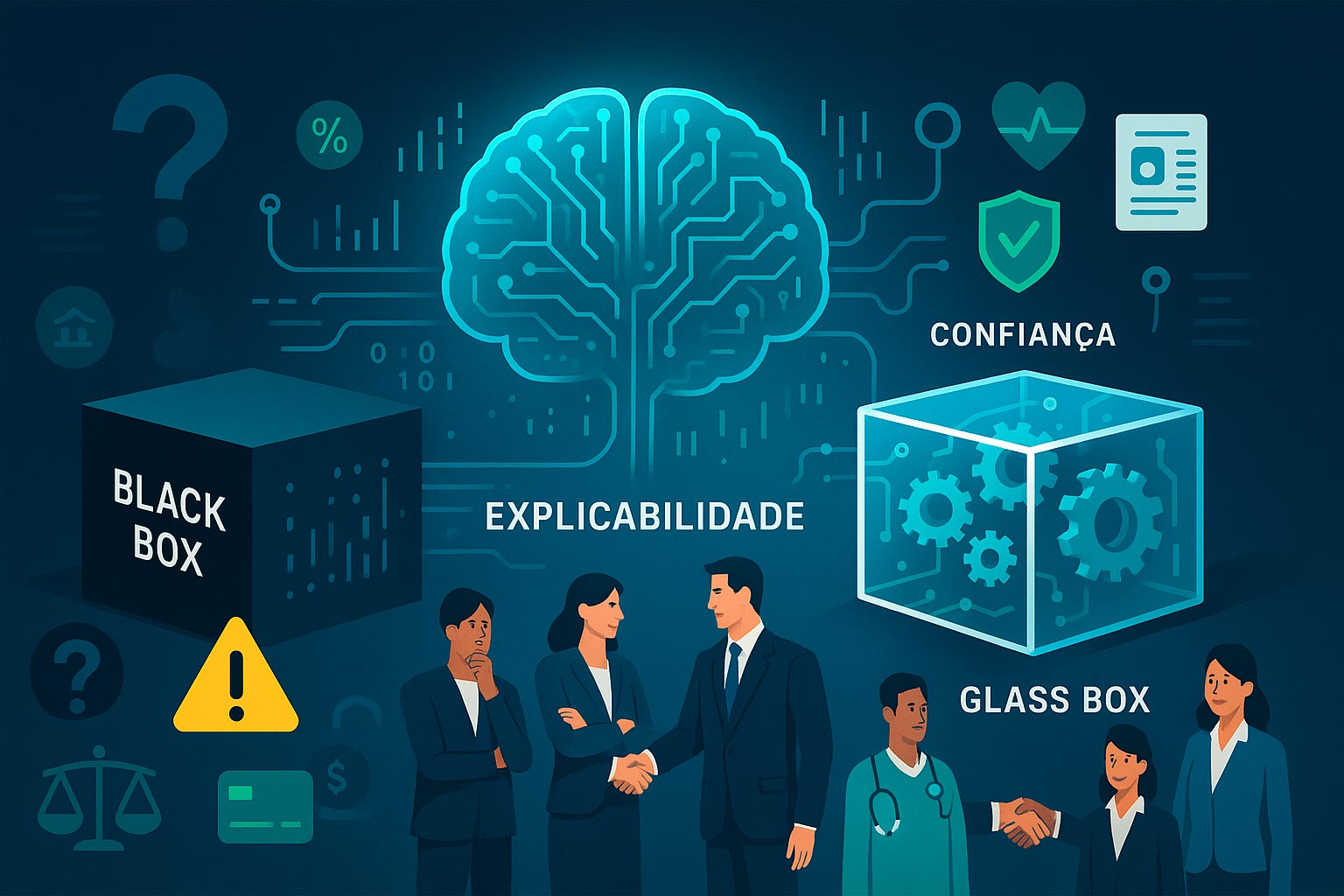

Vivemos em um mundo movido por dados, onde decisões críticas — da concessão de crédito à triagem de currículos, do diagnóstico médico ao controle logístico — são cada vez mais delegadas a sistemas de inteligência artificial. Mas, conforme a IA assume papéis estratégicos nas organizações, surge uma pergunta inevitável: como confiar em decisões tomadas por algoritmos, muitas vezes complexos e opacos, sem compreender seus motivos?

A resposta está em um conceito-chave para o futuro dos negócios: IA Explicável (XAI, do inglês Explainable Artificial Intelligence).

Se antes a prioridade era obter os melhores resultados, hoje as lideranças demandam algo a mais: compreensão, auditabilidade e confiança. XAI não é apenas um diferencial técnico — é um pilar de competitividade, compliance e reputação. Casos concretos mostram que, sem explicabilidade, a IA pode se tornar uma caixa-preta perigosa, gerar perdas, crises de confiança e até danos financeiros e legais. Por outro lado, quando a explicabilidade é priorizada, empresas ganham agilidade, engajamento interno e aceitação do mercado.

A seguir, mergulhe em situações reais — nacionais e internacionais — onde a explicabilidade da IA mudou o rumo de decisões empresariais. Descubra como XAI está desenhando o novo padrão para a adoção responsável de tecnologia no mundo dos negócios.

Caso 1: O algoritmo que negava crédito e o desafio da Caixa-Preta – O caso apple card (EUA)

Em 2019, um escândalo envolvendo a Apple e o banco Goldman Sachs trouxe a explicabilidade da IA ao centro do debate empresarial global. O Apple Card, cartão de crédito lançado com grande expectativa, passou a ser alvo de milhares de reclamações nos EUA: mulheres recebiam limites de crédito significativamente menores do que homens, mesmo com histórico financeiro semelhante.

O problema? O algoritmo usado para calcular o crédito era baseado em machine learning, mas não fornecia explicações claras para suas decisões. O Departamento de Serviços Financeiros do Estado de Nova York abriu investigação para apurar possíveis práticas discriminatórias e, sobretudo, a falta de transparência do sistema automatizado.

Segundo reportagem do The New York Times (NYT, 2019), a Goldman Sachs declarou que o algoritmo “não via gênero”. Porém, a ausência de explicações sobre como os fatores de risco eram ponderados dificultava a defesa do banco, aumentava o risco regulatório e manchava a reputação das marcas envolvidas.

Lição prática: Se o algoritmo fosse explicável desde o início — utilizando ferramentas de XAI como SHAP ou LIME, capazes de mostrar a influência de cada variável em decisões individuais — a empresa teria identificado rapidamente possíveis vieses e comunicado aos clientes de forma transparente, mitigando riscos legais e de imagem.

Caso 2: Diagnóstico médico e vida em jogo – XAI no hospital mount sinai (EUA)

No setor de saúde, a confiança em sistemas de IA é literalmente uma questão de vida ou morte. O Hospital Mount Sinai, em Nova York, foi pioneiro na adoção de IA para prever doenças cardíacas a partir de exames de imagem. Inicialmente, o modelo, baseado em deep learning, apresentou resultados superiores aos dos médicos humanos — mas era uma “caixa-preta”: ninguém conseguia explicar exatamente por que ele indicava alto risco para determinados pacientes.

Isso mudou quando o hospital decidiu adotar ferramentas de XAI. Um estudo publicado pela equipe, em parceria com o MIT e a IBM Research (Nature Medicine, 2019), utilizou técnicas de visualização para identificar os padrões e regiões dos exames que mais influenciavam as decisões do modelo.

O resultado foi imediato: médicos passaram a confiar mais nas recomendações da IA, identificando possíveis falsos positivos e negativos, e podendo questionar ou ajustar a conduta clínica.

Lição prática: A explicabilidade da IA não apenas aumentou a adesão dos profissionais ao sistema, mas também salvou vidas ao permitir a correção de erros e o uso mais criterioso das recomendações algorítmicas.

Caso 3: Justiça algorítmica e o caso COMPAS – Lições do setor público americano

O caso do COMPAS (Correctional Offender Management Profiling for Alternative Sanctions), sistema de IA usado em tribunais dos EUA para prever riscos de reincidência criminal, tornou-se um símbolo dos perigos da falta de explicabilidade.

Investigação da ProPublica (ProPublica, 2016) revelou que o algoritmo apresentava viés racial: pessoas negras eram classificadas com risco maior, mesmo sem evidências proporcionais.

Além do viés, a falta de transparência sobre como o COMPAS tomava decisões gerou uma onda de críticas, revisões judiciais e perda de confiança pública. Só após pressão de órgãos de direitos civis e acadêmicos, iniciaram-se iniciativas para implementar abordagens de XAI — com destaque para o uso de modelos interpretable-by-design e explicações locais das decisões, ajudando tribunais a avaliar a justiça do algoritmo.

Lição prática: Empresas que fornecem soluções para governo ou setores regulados precisam ir além da performance: sem explicabilidade, o risco de escândalo e judicialização aumenta exponencialmente.

Caso 4: XAI no combate à fraude bancária – experiência da Itaú Unibanco (Brasil)

No Brasil, o Itaú Unibanco, um dos maiores bancos da América Latina, adotou estratégias de IA explicável para combater fraudes financeiras. Com dezenas de milhões de transações diárias, o banco já utilizava modelos avançados de machine learning — mas enfrentava o desafio de justificar bloqueios de contas e transações para clientes, reguladores e órgãos de defesa do consumidor.

Em 2021, o Itaú passou a usar técnicas como “Feature Importance” e “Decision Trees Explainability” para mostrar, em linguagem acessível, os fatores que levaram à decisão de bloquear uma conta por suspeita de fraude. A explicabilidade foi integrada tanto ao processo de análise interna quanto à comunicação com o cliente, como relatou o próprio banco em eventos como o AI Summit Brasil (AI Summit, 2021) e artigos publicados no Medium oficial do Itaú (Itaú Tech, Medium).

O resultado foi uma redução de reclamações junto ao Banco Central e aos órgãos de defesa do consumidor, além de um salto de confiança dos próprios times internos na adoção de novas soluções de IA.

Lição prática: Ao tornar a IA mais transparente, empresas do setor financeiro conseguem alinhar inovação e compliance, evitando penalidades e fortalecendo a relação com o cliente.

Caso 5: Diagnóstico médico automatizado no SUS – Projeto do Hospital Israelita Albert Einstein (Brasil)

Outro exemplo brasileiro relevante ocorreu no Hospital Israelita Albert Einstein, que implementou IA para análise de exames de imagens (radiografias e tomografias) em parceria com o SUS, acelerando diagnósticos de Covid-19 e outras doenças.

Segundo artigo publicado na Folha de S.Paulo (Folha, 2020), a maior dificuldade dos médicos em adotar a IA era a falta de transparência dos modelos preditivos — principalmente quando as decisões não batiam com a análise clínica.

Com o uso de XAI, foi possível apresentar “mapas de calor” das imagens que destacavam áreas influentes para o diagnóstico automático, ajudando médicos a entenderem (e confiarem) nas indicações da máquina.

Lição prática: A adoção de IA explicável acelerou o uso da tecnologia no setor público, superando resistências e trazendo benefícios reais ao sistema de saúde.

Caso 6: O Prejuízo de não explicar – O algoritmo de recrutamento da amazon

Nem sempre a história tem final feliz. Em 2018, a Amazon teve que abandonar seu sistema automatizado de triagem de currículos para vagas técnicas após descobrir que o modelo estava rejeitando sistematicamente candidatas mulheres (Reuters, 2018).

A falta de explicabilidade dificultou a identificação do viés a tempo, e o caso tornou-se exemplo global de como a ausência de XAI pode comprometer a adoção e expor empresas a riscos éticos, legais e reputacionais.

Lição prática: Ferramentas de XAI, como auditorias automáticas de viés e explicações individuais de decisão, poderiam ter evitado o fiasco, promovendo um ambiente mais justo e transparente para candidatos e gestores.

Lições e recomendações para líderes empresariais

Os casos apresentados deixam claro: a explicabilidade da IA é um divisor de águas entre inovação sustentável e riscos ocultos. Em setores como finanças, saúde, recursos humanos e governo, a confiança — tanto interna quanto externa — é vital para o sucesso da transformação digital.

- Exija explicações: Toda solução de IA deve permitir a rastreabilidade das decisões. Avalie fornecedores, parceiros e times internos quanto ao uso de ferramentas de XAI (LIME, SHAP, Decision Trees, mapas de calor, etc.).

- Eduque seu time: Treine gestores e analistas para interpretar e comunicar explicações da IA. Um time preparado é o maior aliado da inovação responsável.

- Implemente auditorias contínuas: Use XAI para identificar e corrigir vieses, prevenir riscos e atender às exigências regulatórias de mercados cada vez mais atentos à ética dos algoritmos.

- Comunique-se de forma transparente: Clientes e parceiros querem saber “por quê”. Mostre-se proativo na prestação de contas, fortalecendo reputação e confiança.

Em um cenário onde a inteligência artificial evolui em velocidade recorde, os líderes que abraçarem a explicabilidade sairão na frente — protegendo sua empresa de riscos, conquistando confiança e tornando a inovação verdadeiramente transformadora.

Referências

- NYT: Apple Card Investigated After Gender Bias Allegations

- Nature Medicine: Explainable deep learning models for risk prediction

- ProPublica: Machine Bias – Risk Assessments in Criminal Sentencing

- Itaú Tech – Medium: IA Explicável no Itaú Unibanco

- Folha de S.Paulo: IA acelera diagnóstico da Covid no SUS

- Reuters: Amazon scraps secret AI recruiting tool that showed bias against women

- Gartner: Top Trends in Data and Analytics for 2021 – XAI

Este artigo foi desenvolvido com base em fontes públicas e referência às melhores práticas internacionais sobre IA Explicável.